티스토리 뷰

텐서플로우로 앞서 설명한 단순 선형 회귀를 구현한다.

케라스로 구현해도 좋지만 텐서플로우 먼저 해봄

먼저 경사 하강법에 필요한 미분을 먼저 구현한다.

import tensorflow as tf

w = tf.Variable(2.) #변수 w에 2를 넣는다

def f(w):

y = w**2

z = 2*y + 5

return z

with tf.GradientTape() as tape:

z = f(w)

gradients = tape.gradient(z,[w])

print(gradients)

방정식 f(w)를 구현한다. 이 방정식은 w의 cost값 변화에 대한 그래프이다.

tape.gradient(z,[w])는 타겟(z)에 대한 w의 미분을 계산해주는 메소드이다.

y = w**2을 dy = dx*2*w 미분식을 자동으로 해주는 메소드이다.

위 방정식을 표현해보면 z = 2w*2 + 5이고 미분하면 z' = 4w이다.

처음에 w=2로 정했으니 gradients의 값은 8이 된다.

이제 임의의 w와 b값을 정하고 경사 하강법을 이용해 알맞은 값을 찾는다.

#임의의 w와 b를 지정

w = tf.Variable(4.0)

b = tf.Variable(1.0)

def hypothesis(x):

return w*x + b

x_test = [3.5,5,5.5,6]

print(hypothesis(x_test).numpy())

w와 b에 임의의 값으로 4와 1을 넣고

단순 선형 회귀 모델 y = wx + b를 함수화한다.

그리고 데이터 값 x_test를 설정하고, test값에 대한 y값을 계산한다.

@tf.function #2.x에서 1.x버전도 사용할 수 있게 해 성능 향상에 도움

def mse_loss(y_pred,y):

#두 개의 차이값을 제곱해 평균값 계산

return tf.reduce_mean(tf.square(y_pred - y))

x = [1,2,3,4,5,6,7,8,9] #공부 시간

y = [11,22,33,44,53,66,77,87,95] #성적

#학습률 0.01의 옵티마이저

optimizer = tf.optimizers.SGD(0.01)

#300번의 경사 하강법

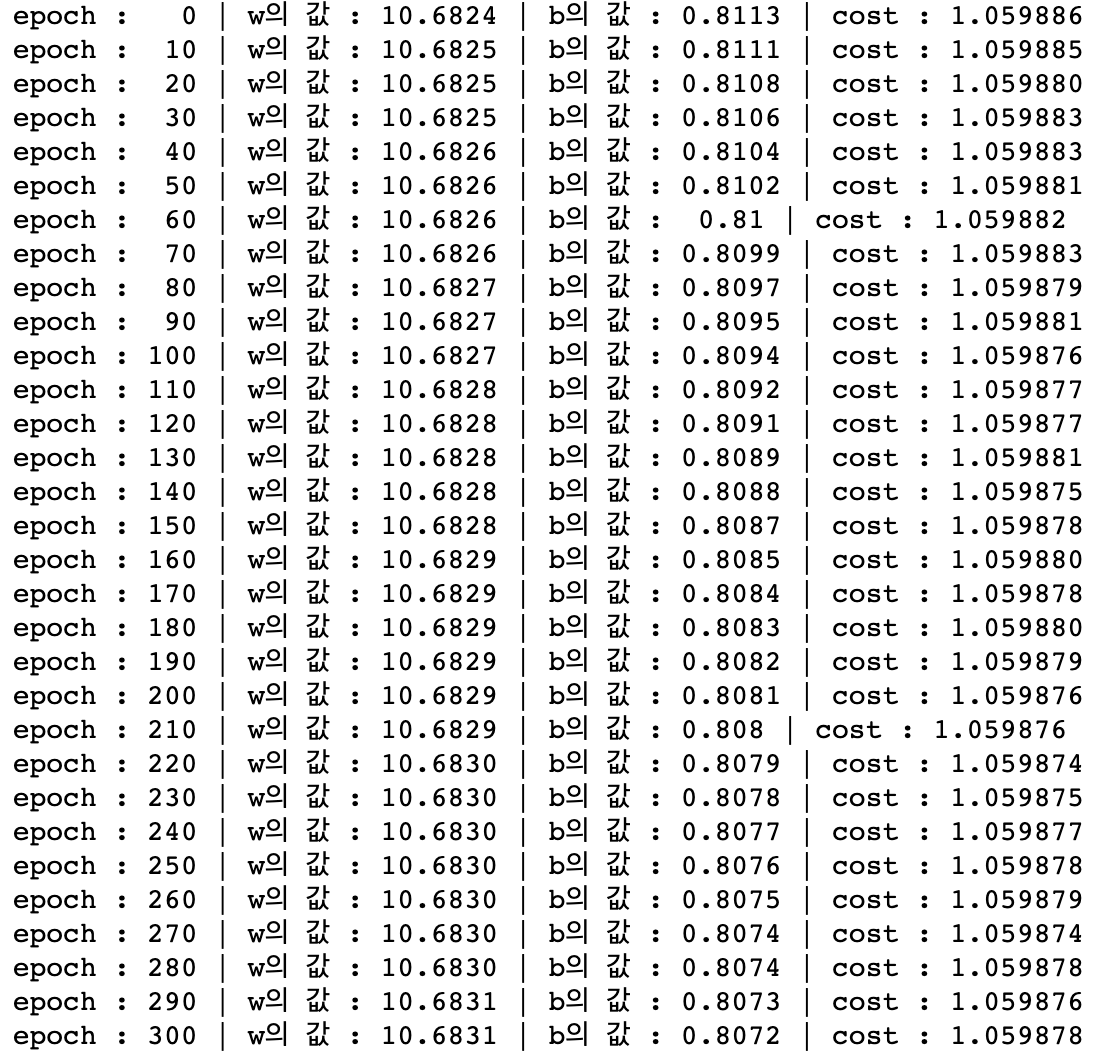

for i in range(301):

#입력값 x에 대한 미분값을 자동으로 계산해주는 gradienttape을 사용

with tf.GradientTape() as tape:

y_pred = hypothesis(x)

cost = mse_loss(y_pred,y)

#손실함수에 대한 파라미터의 미분값 계산

gradients = tape.gradient(cost,[w,b])

#파라미터 업데이트

optimizer.apply_gradients(zip(gradients, [w,b]))

if i % 10 == 0:

print("epoch : {:3} | w의 값 : {:5.4f} | b의 값 : {:5.4} | cost : {:5.6f}".format(i, w.numpy(), b.numpy(), cost))

데이터와 그래프의 평균거리를 구하기 위한 MSE를 계산하는 함수를 구현하고

실제 데이터 x,y를 작성한다.

사용할 옵티마이저의 학습률을 0.01로 정하고

경사 하강법을 300번 실행해 w,b값을 최신화 하면서 cost를 최소화한 값을 찾는다.

w = 10.6831

b= 0.8072

가 최적의 값이다.

'머신러닝' 카테고리의 다른 글

| 머신러닝 / 로지스틱 회귀 (0) | 2023.01.13 |

|---|---|

| 머신러닝 / 단순 선형 회귀 케라스 구현 (0) | 2023.01.13 |

| 머신러닝 / 회귀 (0) | 2023.01.11 |

| 머신러닝/분류 - KNN 알고리즘 (0) | 2023.01.10 |

| 머신러닝 파라미터와 하이퍼 파라미터 (0) | 2022.10.03 |

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- many-to-one

- 케라스

- porks

- one-to-many

- SVM

- 회귀

- 딥러닝

- AE

- Python

- problem statement

- 크로스 엔트로피

- automotive

- AVB

- AVTP

- Ethernet

- PCA

- many-to-many

- CAN-FD

- cuckoo

- automotive ethernet

- 논문 잘 쓰는법

- 로지스틱회귀

- 머신러닝

- json2html

- 단순선형회귀

- 차량 네트워크

- HTML

- 이상탐지

- SOME/IP

- 차량용 이더넷

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | |||||

| 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| 10 | 11 | 12 | 13 | 14 | 15 | 16 |

| 17 | 18 | 19 | 20 | 21 | 22 | 23 |

| 24 | 25 | 26 | 27 | 28 | 29 | 30 |

글 보관함